- 我的订阅

- 科技

我们正处于一个信息大暴发的时代,每天都能产生数以百万计的新闻资讯!

虽然有大数据推荐,但面对海量数据,通过我们的调研发现,在一个小时的时间里,您通常无法真正有效地获取您感兴趣的资讯!

头条新闻资讯订阅,旨在帮助您收集感兴趣的资讯内容,并且在第一时间通知到您。可以有效节约您获取资讯的时间,避免错过一些关键信息。

OpenAI o1模型到博士水平了?复旦教授:没有真正推理能力,学到的还是概率相关性

在进行高达1500亿美元的估值融资之际,OpenAI放出了一个大招,预热了许久的“草莓”(Strawberry) 模型终于来了。

“需要耐心等待的时刻结束了。”该公司CEO山姆·奥特曼(Sam Altman)说。这就是名为 o1的新模型,这次发布包括预览版o1-preview和小尺寸版o1-mini。

OpenAI官方发文称,新模型旨在解决复杂推理问题,训练模型在响应之前花更多时间思考,类似于人类的思考方式。

“新模型在推理能力上代表了AI能力的新水平。”OpenAI称,该模型可以解决科学、编程和数学等更为复杂的任务,且比此前的GPT-4o有显著提升。

奥特曼发帖表示,“这是我们迄今为止功能最强大、最一致的模型,也是迄今为止我们最好的推理模型,这是新范式的开始。”

推理能力吊打GPT-4o,数学编程能力“爆表”

新模型到底有多强?它在需要深入思考和逻辑推理的专业任务上不仅吊打GPT-4o,还超过了拥有博士学位的人类专家。

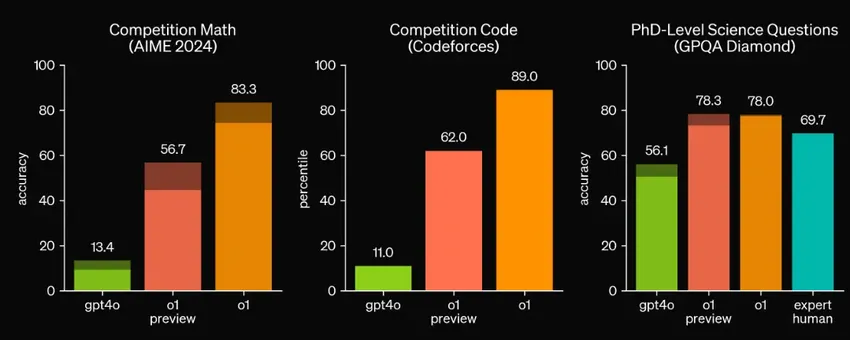

OpenAI表示,新模型在物理、化学和生物等学科的挑战性基准测试中,表现超过人类专家。在国际数学奥林匹克(IMO)资格考试中,新模型得分超83%,远高于GPT-4o的13%。在Codeforces编程竞赛中,o1模型的成绩达到了前89%,而GPT-4o仅达到11%。

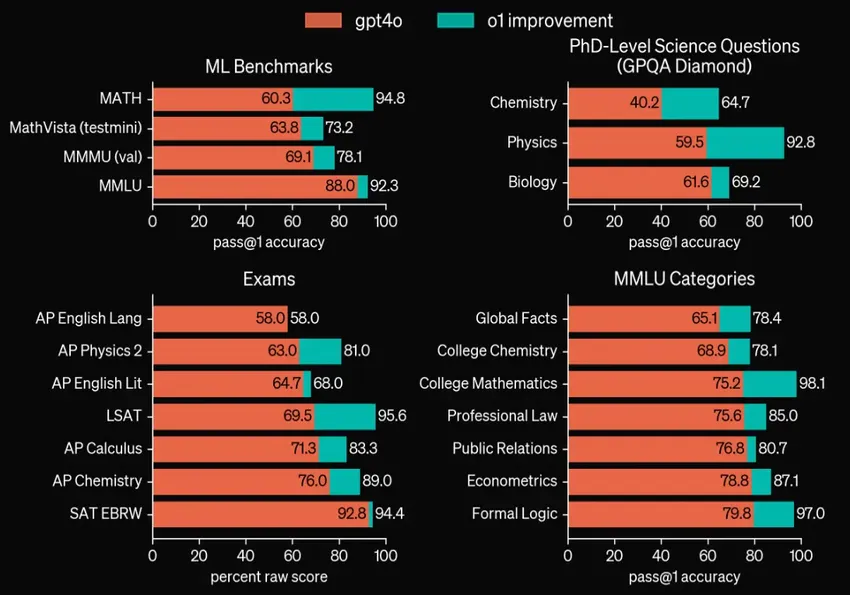

OpenAI表示, o1模型在推理能力上相比GPT-4o显著进步。综合评测显示,在绝大多数需要深入思考和复杂推理的任务中,新模型都展现出了明显优于GPT-4o的表现,并在多个细分测试上超过90%。

在启用视觉感知能力的情况下,o1模型在MMMU(多模态理解)测试中获得了78.2%的高分,成为首个能与人类专家展开竞争的AI模型。

在 MMLU(大规模多任务语言理解)测试中,在总计57个子类别中,o1在54个类别上都超越了GPT-4o 的表现。

上述评测还显示,o1模型在MMLU Categories中的高数测试正确率高达98%,且在ML Benchmarks中的数学测试相较GPT-4o获得了超过34%的最大绝对性优势,足以显示o1模型是个数学超级“学霸”。

OpenAI还选择了专为美国最优秀的高中数学生而设计的高难度考试——美国数学邀请赛(AIME)作为基准,来测试模型的极限能力。

结果显示,在2024年AIME考试中(15题),GPT-4o平均只解决了12%(答对 1.8 )的问题,o1模型测试单次正确率高达74%,64次采样的正确率提升至 83%,1000次采样后使用学习型评分函数重新排序后的正确率高达93%, 即能答对13.9 题,跻身美国前500名学生之列,也超出美国数学奥林匹克竞赛的分数线。

OpenAI进一步将o1模型应用于GPQA diamond 测试,其专门用于评估模型在化学、物理和生物学等领域的专业知识水平,并邀请了拥有相关领域博士学位的专家参与测试。

测试结果显示,o1不仅成功完成了测试,更是超越了博士表现,成为首个在GPQA diamond 基准上击败人类专家的AI模型。

“这些结果并不意味着它在所有方面都比拥有博士学位的专家更强,只是说o1更擅长解决一些博士能够解决的特定问题。”OpenAI称。

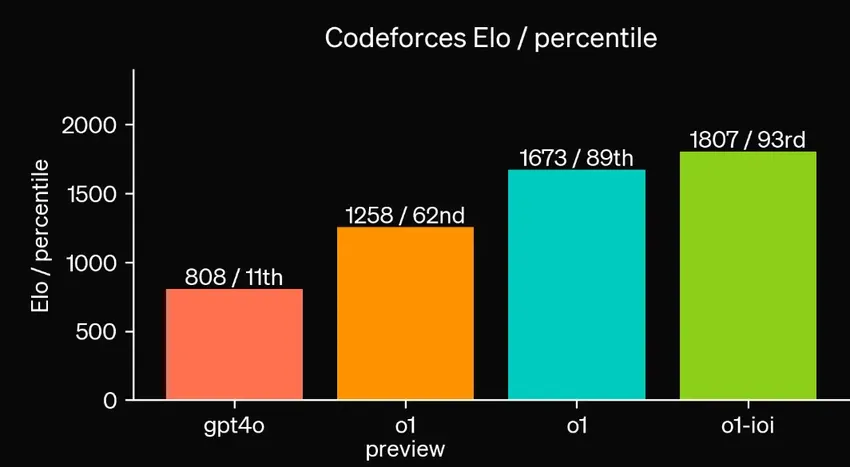

在编程方面,OpenAI基于o1模型深度优化和专项训练出一个新的AI模型,其在2024年国际信息学奥林匹克竞赛(IOI)获得了213分的高分,跻身参赛者的前50%。

在Codeforces平台的模拟竞争性编程比赛中,该新模型超越了93%的人类竞争者。相比之下,GPT-4o仅超过11%的人类竞争者。

这些评测显示出,新模型不仅在数学、编程等需要高推理能力的专业领域可比肩人类专家,同时在更为广泛的多模态和语言理解方面也有更好表现。

OpenAI发布的一项匿名人类偏好评估显示,o1-preview在数据分析、编码和数学等推理密集型类别中,比GPT-4o更受欢迎,但在某些自然语言任务中,o1-preview并不是首选。这表明它并不适合所有用例,GPT-4o在文本生成方面仍保持优势。

OpenAI负责新模型研发的员工也提到,o1模型并不总是比GPT-4o更好,许多任务并不需要推理能力,有时等待o1的回应相比快速获得GPT-4o的回应并不值得。

“作为早期模型,o1-preview还不具备ChatGPT的许多实用功能,如浏览网页、上传文件和图片。对于许多常见情况,GPT-4o短期内变得更加强大。但对于复杂的推理任务来说,这是一个重大进步,代表了人工智能能力的新水平。”OpenAI表示。

强化学习+思维链加持,幻觉依然无法彻底解决

o1模型更强的推理能力得益于OpenAI开发了一种创新的大规模强化学习算法。这种算法不仅能高效利用数据,还能有效训练模型运用思维链进行推理思考。

这种训练的核心在于教会模型“如何思考”。因此,与传统模型追求的快速响应不同,新模型开始学会慢思考——在回答之前,内部进行长链条的思考和推理,确保生成内容的质量。在OpenAI的一项单词推理测试中,o1-preview响应时间达32秒,而GPT-4o仅需3秒。

“我们训练这些模型花更多的时间去思考问题,然后再做出反应,就像人类一样。”OpenAI称,借助强化学习和思维链,新模型能完善自己的思维过程,具备自我检查的能力,识别纠正出现的错误,可以将复杂问题进行分解,并能在发现当前方法无效时尝试不同的策略。

OpenAI还发现,随着强化学习计算量的增加,以及模型思考时间的延长,o1的性能会不断提高。这显示新模型更多依赖计算资源和算法优化,而传统大语言模型预训练则依赖于海量数据的收集处理。

“这有很大不同,我们正深入研究这种新方法的扩展限制。”OpenAI表示,模型思考的时间越长,在推理任务上的表现就越好。“这开辟了一个新的扩展维度,不再受预训练的瓶颈限制,现在也可以扩展推理计算能力。”

得益于这些技术创新所带来的能力,OpenAI将新模型计数器重置为 1,并命名为o1。

某种程度来说,这意味着大模型的“摩尔定律”Scaling Law有效,但重点已从堆数据,转移到堆算力和算法优化方面,提高模型思考时间,可以说是一条提升大模型能力的新路径。

英伟达的科学家Jim Fan对此也点评称,模型不仅仅拥有训练时的Scaling law,还拥有推理层面的Scaling law,双曲线的共同增长,将突破大模型能力的提升瓶颈。

同时,OpenAI表示,思维链推理为AI对齐和安全提供了新的机会。“这是教授模型人类价值观和原则的有效方法,推理能力的提升有利于模型稳健性,并使我们能够以清晰的方式观察模型思维的过程。”

不过,这仍然无法彻底解决幻觉问题,但思维链为AI的三大缺陷(不可信、不可控、不透明)提供了思路。它可以“读取模型的思想”并理解其思维过程,检测AI是否试图操纵用户,以及为 AI决策提供解释性,增加透明度和可信度。

OpenAI总裁Greg Brockman也提到,这提供了新的安全机会,公司正在积极探索,包括可靠性、幻觉和对抗攻击者的鲁棒性。

“在权衡了用户体验、竞争优势、思维链监控和安全等在内的多种因素后,我们决定不向用户展示原始思维链。”OpenAI表示,o1模型会提供由模型生成的思维链摘要。

预览版成本比GPT-4o贵三四倍,9.11和9.8谁大仍翻车

“发布o1-preview的一个动机是为了观察哪些使用场景会变得流行,以及这些模型在哪些方面还需要改进。”OpenAI员工称。

该公司表示,新模型将为多个领域的专业人士带来显著助益,尤其是那些在科学研究、软件开发、数学计算等领域面临复杂挑战的领域,将是一个辅助工具。

ChatGPT Plus和Team用户从今天开始可以在ChatGPT 中访问 o1 模型。ChatGPT Enterprise 和Edu用户将从下周开始获得访问权限。

部分开发者今日起也可使用o1-preview和o1-mini,速率限制为20 RPM。OpenAI计划在未来向所有ChatGPT的免费用户开放o1-mini的使用权。

对开发者来说,使用o1模型要付出更高的价格。目前,o1-preview输入定价15美元/百万token,是GPT-4o(5美元/百万token)的3倍;输出定价60美元/百万token,是GPT-4o(15美元/百万token)的4倍。

不过,开发者可以选择小版本的o1-mini。相较o1-preview,它速度更快、成本更低,适用于需要推理但没有广泛知识的应用程序,尤其擅长数据和编码,成本比o1-preview低80%,即和GPT-4o价格相当。

对于OpenAI此次发布的新模型,复旦大学计算机科学技术学院教授、MOSS大模型核心人员张奇对搜狐科技表示,它依然不具备真正的推理能力。

“统计机器学习进行可以拟合数据集,但是无法进行类人的演绎和归纳推理,它学习到的仍然是概率相关性。”张奇表示。

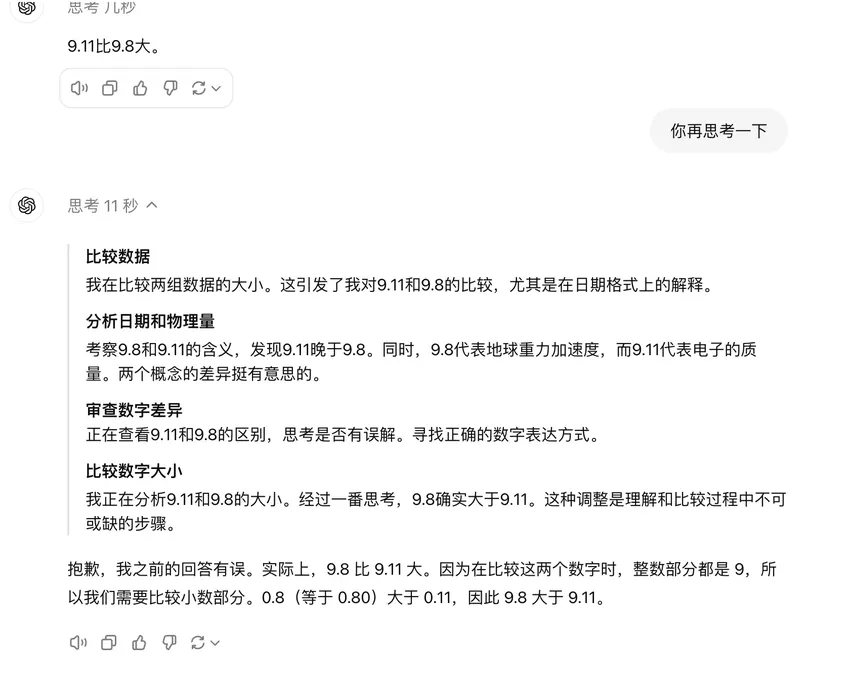

他提到,换一些简单题目,与训练语料不同的数据,o1-preview的结果就会变的很差。比如虽然它数学能力突出,但对9.11和9.8哪个大这种问题,第一次回答时仍然翻车,而在进行第二次反馈后,它才从不同角度解读,最后给出了正确答案。

这意味着,评测代表的是评测数据集的能力,但用到具体的实际场景,OpenAI新模型的首次输出准确性仍有很大的改进空间。实际上,Open发布的前述评测中,部分表现突出的结果都是多次测试综合得出。

OpenAI称,o1模型还处于早期,未来将进行定期更新和改进,后续会加入更多功能,如网页浏览、文件和图像上传等。同时,会继续开发GPT系列模型,与o1系列模型并行发展。

这意味着,我们还是有机会见到GPT-5,你还期待吗?

以上内容为资讯信息快照,由td.fyun.cc爬虫进行采集并收录,本站未对信息做任何修改,信息内容不代表本站立场。

快照生成时间:2024-09-13 18:45:01

本站信息快照查询为非营利公共服务,如有侵权请联系我们进行删除。

信息原文地址: