- 我的订阅

- 科技

我们正处于一个信息大暴发的时代,每天都能产生数以百万计的新闻资讯!

虽然有大数据推荐,但面对海量数据,通过我们的调研发现,在一个小时的时间里,您通常无法真正有效地获取您感兴趣的资讯!

头条新闻资讯订阅,旨在帮助您收集感兴趣的资讯内容,并且在第一时间通知到您。可以有效节约您获取资讯的时间,避免错过一些关键信息。

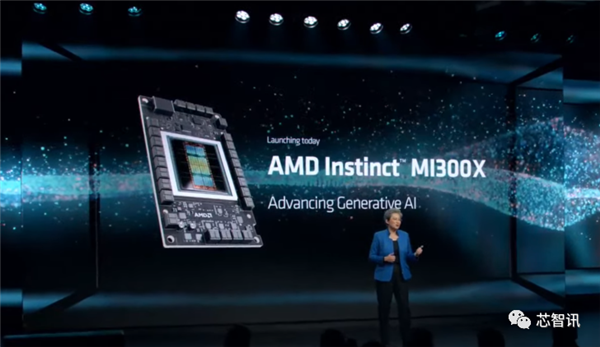

AMD最强AI芯片发布:性能是英伟达H100的1.3倍!

12月7日消息,AMD于当地时间周三举行了“AdvancingAI”发布会,正式推出了面向AI及HPC领域的GPU产品InstinctMI300A/MI300X加速器,直接与英伟达(NVIDIA)H100加速器竞争。

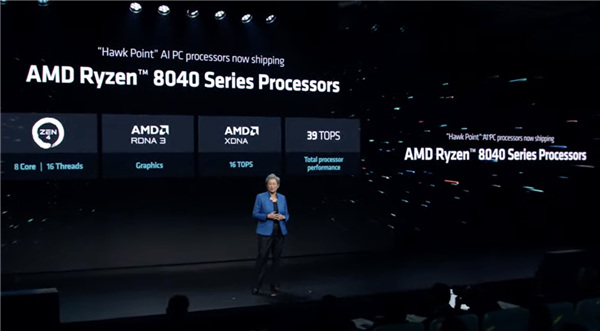

同时AMD还发布了代号为HawkPoint的最新一代Ryzen8000系列APU,可面向AIPC产品。

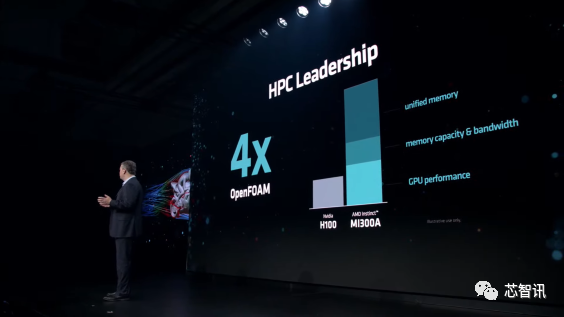

MI300A:HPC性能达到NVIDIAH100的4倍

虽然在今年6月的“数据中心与人工智能技术发布会”,AMD就有发布MI300A和MI300X,只不过当时MI300X只是纸面上的发布,现在MI300A和MI300X已经开始批量量产了,AMD也公布了更多关于MI300A、MI300X的性能数据。

AMDMI300A采用了Chiplet设计,其内部拥有多达13个小芯片,均基于台积电5nm或6nm制程工艺(CPU/GPU计算核心为5nm,HBM内存和I/O等为6nm),其中许多是3D堆叠的,以便创建一个面积可控的单芯片封装,总共集成1460亿个晶体管。

具体来说,MI300A与上一代的MI250X一脉相承,采用新一代的CDNA3GPU架构,拥有228个计算单元(14592个核心),并集成了24个Zen4CPU内核,配置了128GB的HBM3内存。

MI300A的计算核心被8个HBM3内存包围,单个HBM3的带宽为6.3GB/s,八个16GB堆栈形成128GB统一内存,带宽高达5.3 TB/s。

在算力方面,MI300A提供了高达61TFLOPSFP64算力,多达122TFLOPSFP32算力。

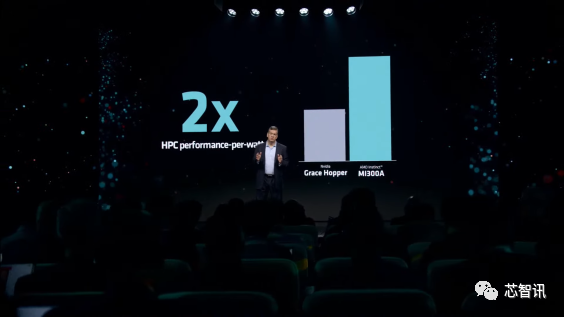

AMD表示,MI300AGPU将HPC提升到一个新的水平,其性能是NVIDIAH100的4倍,能效是H100的两倍。

具体来说,在OpenFOAM中,MI300AAPU提供了相比H100高达4倍的性能提升,这主要来自于统一的内存布局、GPU性能以及整体内存容量和带宽。与NVIDIA的GraceHopper超级芯片相比,该系统每瓦的性能也提高了2倍。

AMD证实,MI300A目前正在发货,还将用于为下一代ElCapitan超级计算机提供动力,预计该超级计算机将提供高达2Exaflops的计算能力。

值得一提的是,AMD是唯一一家凭借Frontier超级计算机突破1Exaflop大关的公司,也是地球上效率最高的系统。此外,惠普、Eviden、技嘉、超微等也将是MI300A加速器的OEM和解决方案合作伙伴。

MI300X:AI性能比英伟达H100高出30%!

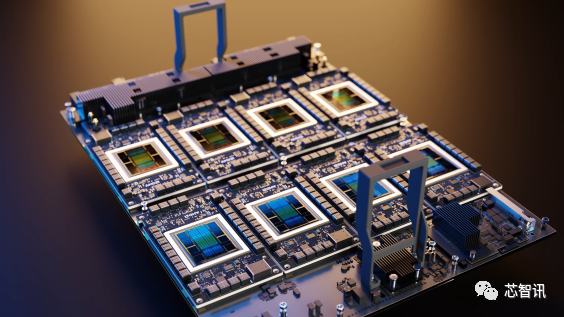

MI300X采用了相比MI250X更简单的设计,MI300X内部集成了12个5/6nm工艺的小芯片(HMB和I/O为6nm),拥有1530亿个晶体管,放弃了APU的24个Zen4内核和I/O芯片,取而代之的是更多计算核心的CDNA3GPU。

MI300X的每个基于CDNA3GPU架构的GCD总共有40个计算单元,相当于2560个内核。总共有八个计算芯片(GCD),因此总共有320个计算和20480个核心单元。不过,就目前的量产版而言,AMD缩减这些核心的一小部分,因此实际总共有304个计算单元(每个GPU小芯片38个CU)可用于19456个流处理器。

在内存带宽方面,MI300X也配备了更大的192GBHBM3内存(8个HBM3封装,每个堆栈为12Hi)相比MI250X提高了50%,带来高达5.2TB/s的带宽和896GB/s的InfinityFabric带宽。相比之下,英伟达即将推出的H200AI加速器提供141GB的容量,而英特尔即将推出的Gaudi3将提供144GB的容量。大型内存池在LLM(大语言模型)中非常重要,LLM大多是与内存绑定的,AMD可以通过在HBM内存容量上的领先地位来提升器人工智能能力。

具体来说,AMD的MI300X与英伟达的H100加速器相比:

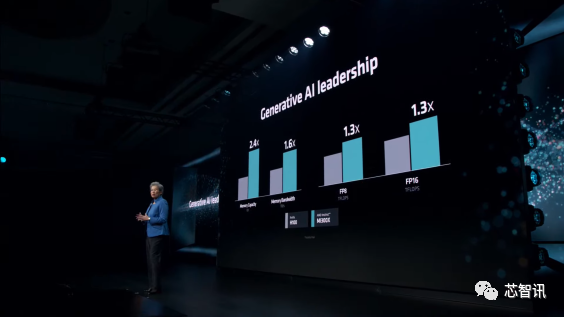

内存容量提高2.4倍

内存带宽提高1.6倍

1.3倍FP8TFLOPS

1.3倍FP16TFLOPS

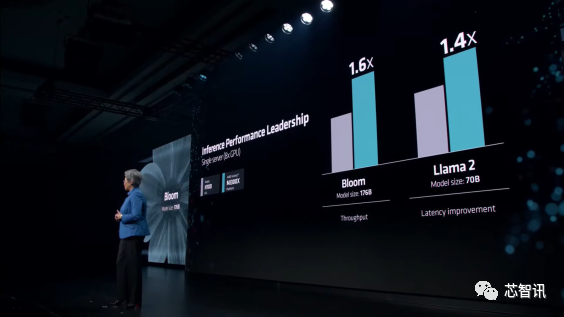

在1v1比较中,速度比H100(Llama270B)快达20%

在1v1比较中,速度比H100(FlashAttention2)快达20%

8v8服务器中的速度比H100(Llama270B)快达40%

在8v8服务器中,速度比H100(Bloom176B)快达60%

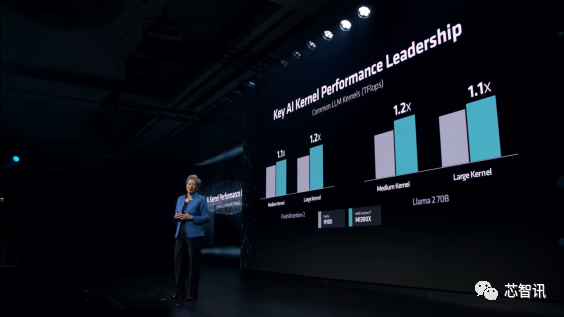

在具体的AI大模型加速性能对比当中,MI300X相比H100在FlashAttention-2和Llama270B中提供了高达20%的性能提升。

从平台角度来看,将8xMI300X解决方案与8XH100解决方案进行比较,前者在Llama270B中获得了更大的40%的性能提升,而在Bloom176B中则获得了60%的性能提升。

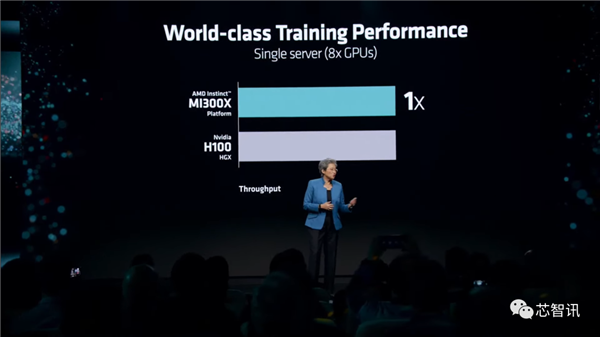

AMD指出,在AI训练性能方面,MI300X与竞争对手(H100)相当,并提供有竞争力的价格/性能,同时在推理工作负载方面表现出色。

在功耗方面,AMDMI300X的额定功率为750W,比MI250X的500W增加了50%,比NVIDIAH200多了50W。

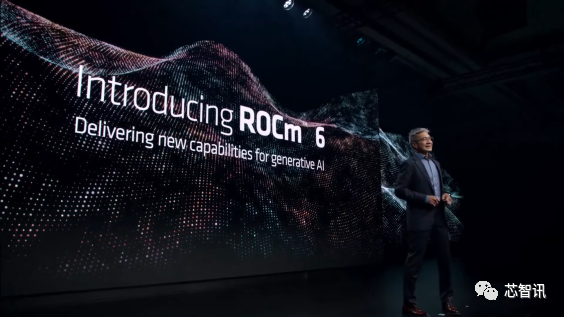

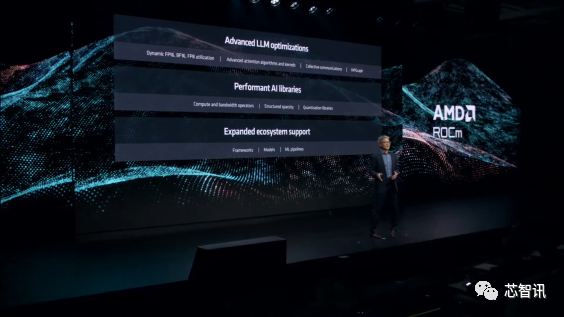

ROCm 6.0开放软件平台

AMD还推出了ROCm6.0开放软件平台,该最新版本具有强大的新功能,包括支持各种人工智能工作负载,例如生成式人工智能和大型语言模型。

新的软件堆栈支持最新的计算格式,例如FP16、Bf16和FP8(包括Sparsity)等。

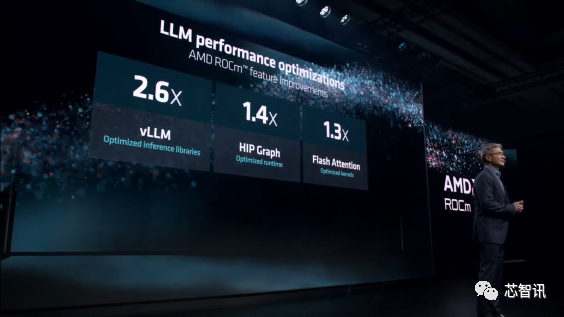

这些优化相结合,通过优化的推理库将vLLM的速度提高了高达2.6倍,通过优化的运行时间将HIPGraph的速度提高了1.4倍,并通过优化的内核将FlashAttention的速度提高1.3倍。

AMD指出,与上一代软硬件组合相比,使用MI300X和ROCm6跑Llama270B文本生成,AI推理速度提高了约8倍。

ROCm 6预计将于本月晚些时候与MI300AI加速器一起推出。看看ROCm6与NVIDIACUDA堆栈的最新版本(它的真正竞争对手)相比如何,将会很有趣。

G593-ZX1/ZX2系列服务器

AMD还展示了一种配置是Gigabyte的G593-ZX1/ZX2系列服务器,它提供多达8个MI300XGPU加速器和两个AMDEPYC9004CPU。这些系统将配备多达八个3000W的电源,总功率为18000W。

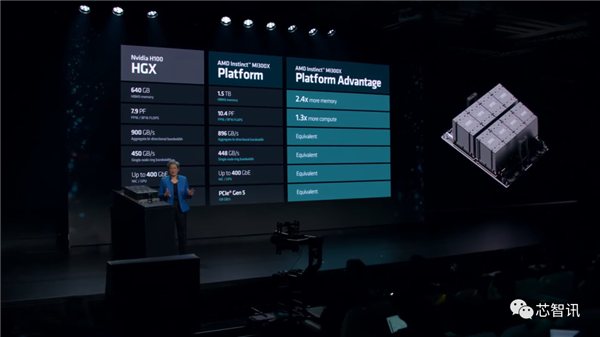

据介绍,该集成了8个MI300XGPU的加速器平台,相比NVIDIAHGXH100平台,带来的提升包括:

2.4倍更高的HBM3内存(1.5TBvs.640GB)

1.3倍以上的计算FLOPS(10.4PFvs.7.9PF)

类似的双向带宽(896GB/svs.900GB/s)

类似的单节点环形带宽(448GB/svs.450GB/s)

类似的网络功能(400GbEvs.400GbE)

类似的PCIe协议(PCIeGen5128GB/s)

据semianalysis此前报道,微软、Meta、甲骨文、谷歌、Supermicro/Qunta-direct、亚马逊等公司已经向AMD下了不同数量的MI300系列订单。

今天,微软也宣布将评估对AMD的AI加速器产品的需求,评估采用该新品的可行性。Meta公司也宣布将在数据中心采用AMD新推的MI300X芯片产品。甲骨文也表示,公司将在云服务中采用AMD的新款芯片。

此前市场预计AMD的MI300系列在2024年的出货约为30~40万颗,最大客户为微软、谷歌,若非受限台积电CoWoS产能短缺及英伟达早已预订逾四成产能,AMD出货有望再上修。

值得注意的是,在不久前的财报会议上,AMDCEO苏姿丰(LisaSu)表示,“基于我们在人工智能路线图执行和云客户购买承诺方面取得的快速进展。

根据预计,随着全年收入的增加,数据中心GPU的收入在第四季度将约为4亿美元,2024年将超过20亿美元。这一增长将使MI300系列成为AMD历史上销售额最快增长至10亿美元的产品。

目前,在生成式AI的热潮之下,英伟达凭借其AI芯片的出色性能及CUDA的生态优势,在云端AI芯片市场占据者垄断优势。不过,由于英伟达的AI芯片价格高昂以及供应短缺,云服务及AI技术厂商们处于成本及多元化供应链安全考虑,也使得AMD和英特尔等竞争者有了更多的机会。

Ryzen8040系列发布:主频高达5.2 GHz,AI性能提升60%

代号为“HawkPoint”的Ryzen8040系列APU是专为客户端和消费类PC设计的处理器,主要针对笔记本电脑市场,其中高端的版本可面向AIPC。

AMDRyzen8040系列配备了与上一代相同的4nmZen4CPU核心架构,最多8核/16线程,只不过主频提高到了5.2GHz;

拥有相同的RDNA3图形核心架构,高达Radeon780MiGPU(12个计算单元);

升级了XDNANPU,拥有16TOPS的AI算力,AI性能相比上一代提升了60%。

TDP范围为15-54W。将于2024年第一季度推出PC产品。

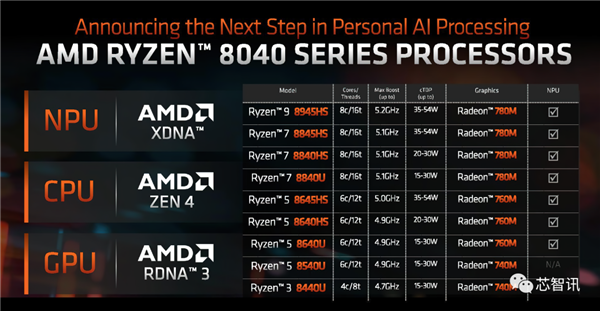

该产品线主要分为三个部分,首先是高端Ryzen8045HS系列,它将成为具有最高时钟速度的佼佼者,然后是更主流的Ryzen8040HS系列,以及专为功耗优化平台设计的入门级 Ryzen8040U系列。

具体来说,AMDHawkPoint系列共有9个Ryzen8040SKU。首先是Ryzen8045HSSKU,其中包括Ryzen98945HS、Ryzen78845HS和Ryzen58645HS。

这三款芯片与Ryzen97940HS、Ryzen77840HS和Ryzen57640HSSKU具有相同的规格,最多8/6个核心、Radeon780M/760MiGPU、高达5.2GHz时钟速度、16MB总L3缓存和35-54WTDP。

AMDRyzen8040HSSKU,主要有Ryzen78840HS和Ryzen58640HS。

这两个SKU设计为低功耗产品,目标功率为20-30W。

Ryzen78840HSAPU具有8核、16线程、16MB缓存、Radeon780MiGPU,时钟速度高达5.1GHz,而Ryzen58640HSAPU具有6核、12线程、16MB三级缓存、Radeon760MiGPU和高达4.9GHz的时钟。

这些芯片将配备较低的基本时钟,并具有额外的热量/功率限制,以满足功率受限的PC的要求。

最后,AMDRyzen8040USKU,其配置再次与Ryzen7040USKU相同。

有四种SKU,包括Ryzen78840U、Ryzen58640U、Ryzen58540U和Ryzen38440U。8540U和8440U缺少NPU,因为它们基于包含Zen4和Zen4C内核的较小混合芯片。

这些低功耗解决方案没有包含专用的XDNANPU。这些SKU仅配备Radeon740MiGPU,其中包含4个计算单元。

谈到使用更小的Zen4C内核的优势,最明显的一个是更小的芯片尺寸,这可以带来更高的密度和更高的功率效率。AMD表示Zen4C核心提供:

更高的效率:具有相同IPC的较小内核可以使用更少的功率来提供低于15W的更高性能。

高级版的可扩展性:具有相同IPC的较小内核开启了高端市场未来内核数量增加的潜力。

入门级的可扩展性:具有相同IPC的较小内核使AMD能够为消费者提供更多选择。

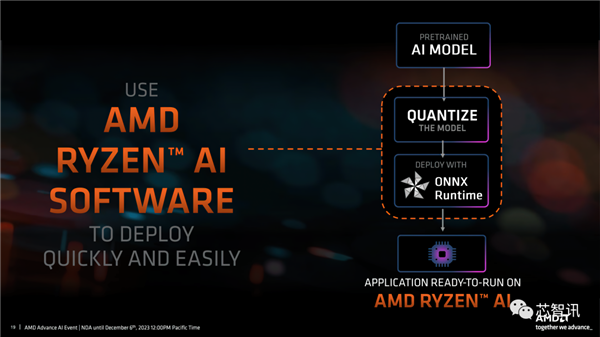

全新的AMDRyzen8040“HawkPoint”APU系列的一个主要目的是吸引买家进入AIPC生态系统。

即将推出的Windows版本Windows12在人工智能方面预计将是一件大事,有传言强调,主要要求之一将是具有足够TOP的专用NPU来处理新操作系统的人工智能处理功能。

因此,AMD升级了这些新APU上的NPU,可提供多达16TOPS的AI计算能力。

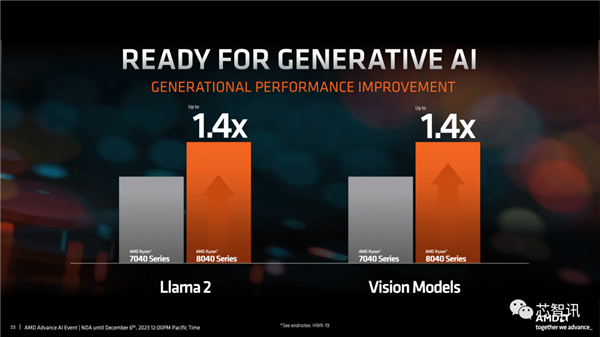

AMD自己也宣称Ryzen 8040系列使用Llama2和Vision模型的性能提升了40%。AMD还致力于通过驱动程序和RyzenAI软件套件的各种改进来微调其ML和AI性能。

值得注意的是,很快英特尔即将在美国当地时间12月14日正式发布面向AIPC全新酷睿Ultral处理器。而在此之前,高通也已经推出了面向AIPC的骁龙XElite处理器。

据市场研调机构Canalys最新的预测显示,2024年个人电脑(PC)出货量有望同比增长8%至2.67亿台。而这其中,AIPC将是增长动能之一,2024年AIPC比重将达19%,出货量将超过5000台。

以上内容为资讯信息快照,由td.fyun.cc爬虫进行采集并收录,本站未对信息做任何修改,信息内容不代表本站立场。

快照生成时间:2023-12-08 06:45:56

本站信息快照查询为非营利公共服务,如有侵权请联系我们进行删除。

信息原文地址: