- 我的订阅

- 科技

我们正处于一个信息大暴发的时代,每天都能产生数以百万计的新闻资讯!

虽然有大数据推荐,但面对海量数据,通过我们的调研发现,在一个小时的时间里,您通常无法真正有效地获取您感兴趣的资讯!

头条新闻资讯订阅,旨在帮助您收集感兴趣的资讯内容,并且在第一时间通知到您。可以有效节约您获取资讯的时间,避免错过一些关键信息。

OpenAI Triton开始合并AMD ROCm 代码

9月3日消息,Triton是一种类似于Python的开源编程语言,它可以使没有CUDA经验的研究人员顺利编写高效的GPU代码(可以理解为简化版CUDA),而且号称小白也可以写出与专业人士相媲美的代码,就是让用户用相对较少的努力实现最高的硬件性能,但Triton初期只支持英伟达GPU。

OpenAI声称:Triton只要25行代码,就能在FP16矩阵乘法上达到与cuBLAS相当的性能。

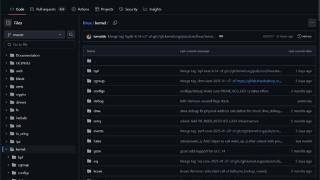

从Github我们可以看到,OpenAI已经开始在最新的Triton版本中合并AMDROCm相关分支代码,也正因此暴露了很多东西。也就是说,最新Triton后端已适配AMD平台,可谓意义重大。

通过官方的说法来看,他们已经通过了“test_core.py”上的大多数单元测试环节,但由于各种原因跳过了一些测试。

IT之家注意到,OpenAI还宣布将于9月20日上午10点至下午4点在加利福尼亚州山景城的微软硅谷园区举行Triton开发者大会,而日程安排中就包括“将Triton引入AMDGPU”和“Triton的英特尔XPU”两大环节,预计Triton将很快摆脱英伟达CUDA垄断的历史。

值得一提的是,Triton是开源的,比起闭源的CUDA,其他硬件加速器能直接集成到Triton中,大大减少了为新硬件建立AI编译器栈的时间。

在此前发布的PyTorch2.0版本中,TorchInductor便引入了OpenAITriton支持,可为多个加速器和后端自动生成快速代码,同时实现用Python取代CUDA编程来写底层硬件的代码。也就是说,Triton已经是PyTorch2.0后端编译器关键构成部分。

实际上,此前AMDROCm则主要是采用 Hipify工具实现CUDA兼容,而随着AMD开始为RDNA3消费级显卡提供ROCm支持,预计后续将会有更多平台选择适配AMD硬件。

以上内容为资讯信息快照,由td.fyun.cc爬虫进行采集并收录,本站未对信息做任何修改,信息内容不代表本站立场。

快照生成时间:2023-09-03 23:45:03

本站信息快照查询为非营利公共服务,如有侵权请联系我们进行删除。

信息原文地址: