- 我的订阅

- 科技

我们正处于一个信息大暴发的时代,每天都能产生数以百万计的新闻资讯!

虽然有大数据推荐,但面对海量数据,通过我们的调研发现,在一个小时的时间里,您通常无法真正有效地获取您感兴趣的资讯!

头条新闻资讯订阅,旨在帮助您收集感兴趣的资讯内容,并且在第一时间通知到您。可以有效节约您获取资讯的时间,避免错过一些关键信息。

微软打造 13 亿参数小型 LLM AI 模型

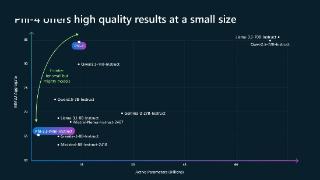

AI模型盲堆体积实际上效果并不见得更好,更多要看训练数据的质量,微软日前最近发布了一款13亿参数的语言模型phi-1,采用“教科书等级”的高品质资料集训练而成,据称“实际效果胜于千亿参数的GPT3.5”。

▲图源Arxiv

注意到,该模型以Transformer架构为基础,微软团队使用了包括来自网络的“教科书等级”数据和以GPT-3.5经过处理的“逻辑严密的内容”,以及8个英伟达A100GPU,在短短4天内完成训练。

▲图源Arxiv

微软团队表示,比起增加模型的参数量,通过提高模型的训练数据集质量,也许更能强化模型的准确率和效率,于是,他们利用高质量数据训练出了phi-1模型。在测试中,phi-1的分数达到50.6%,比起1750亿参数的GPT-3.5(47%)还要好。

▲图源Arxiv

微软表示,phi-1接下来会在HuggingFace中开源,而这不是微软第一次开发小型LLM,此前,他们打造一款130亿参数的Orca,使用了GPT-4合成的数据训练而成,表现也同样比ChatGPT更好。

目前关于phi-1的论文已经在arXiv中发布,可以在这里找到论文的相关内容。

以上内容为资讯信息快照,由td.fyun.cc爬虫进行采集并收录,本站未对信息做任何修改,信息内容不代表本站立场。

快照生成时间:2023-06-28 06:45:31

本站信息快照查询为非营利公共服务,如有侵权请联系我们进行删除。

信息原文地址: