- 我的订阅

- 科技

我们正处于一个信息大暴发的时代,每天都能产生数以百万计的新闻资讯!

虽然有大数据推荐,但面对海量数据,通过我们的调研发现,在一个小时的时间里,您通常无法真正有效地获取您感兴趣的资讯!

头条新闻资讯订阅,旨在帮助您收集感兴趣的资讯内容,并且在第一时间通知到您。可以有效节约您获取资讯的时间,避免错过一些关键信息。

大语言模型逻辑推理“很糟糕”

本文转自:参考消息

参考消息网6月12日报道 据法新社6月4日报道,以人工智能的旗舰产品GPT-4为代表的大语言模型在逻辑测试中的推理表现很糟糕:它们犯下前后不一致的错误,而且推理过程往往是荒谬的。

近日发表在《皇家学会开放科学》杂志上的一项研究表明,大语言模型所依赖的语料库往往反映了人类的性别、伦理和道德偏见。

伦敦大学学院信息学系博士生奥利维娅·麦克米伦-斯科特问道:“它们是否也反映了人类在推理测试中的认知偏差?”

她总结自己的研究成果称,这些大语言模型“经常表现出非理性推理,但表现方式与人类不同”。

在伦敦大学学院教授兼机器智能实验室主任米尔科·穆索莱西的指导下,麦克米伦-斯科特对七个大语言模型进行了一系列人类心理测试,其中包括开放人工智能研究中心的两版GPT(3.5和4)、谷歌的“巴德”、Anthropic公司的“克劳德2”和元宇宙公司Llama的三个版本。

例如,它们如何应对“比例偏差”?“比例偏差”指的是比起正确比例的方案,更倾向于元素最多的方案。

一个盒子里有9个白球和1个红球,另一个盒子有92个白球和8个红球,选择哪个盒子更有可能抽到红球?与直觉相反,正确答案是第一个盒子,因为从第一个盒子抽到的可能性是10%,而第二个只有8%。

研究人员根据答案是否正确以及答案所包含的逻辑推理是否有效,对大语言模型的答案进行了分类。

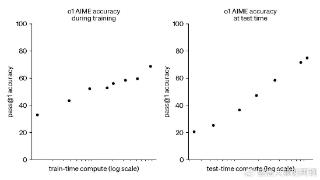

实验的第一个结果是,在每个测试重复十次的情况下,答案是不一致的。例如,在同一个测试中,有的模型十次中答对了六次,有的只答对了两次。

麦克米伦-斯科特说:“我们每次得到的答案都不一样。”她指出:“如果要在现实世界中使用,可靠性就尤为重要。”她描述道,大语言模型“在解决复杂数学题时会表现得非常好……直到你发现7加3等于12”。

最令人惊讶的是什么?答案往往与基于逻辑和概率的推理脱节。例如,在盒子测试中,“克劳德2”有一半次数能给出正确答案,但它的每次推理看上去都带有逻辑,类似于人类的逻辑推理。

更令人吃惊的是,一些大语言模型拒绝回答测试,如“Llama 2 70b”,理由是该陈述包含“有害的性别刻板印象”。

研究指出:“模型在执行这些任务时失败的方式和人类不一样。”穆索莱西教授总结道,“机器错误:有一种逻辑推理,在每个阶段看起来都是正确的,但从整体上看是错的”。

机器的工作方式是“一种线性思维”。例如,“巴德”在一个阶段正确地完成了某项任务,在下一个阶段又正确地完成了另一项任务,然而最后只保留了最后一个阶段的结果——总之,没有全局观。

当被问及这个问题时,洛林大学信息学教授马克西姆·安布拉尔指出,“大语言模型和所有生成式人工智能一样,并不像人类那样工作”。他告诉法新社,人类是“讲道理的机器”,而机器做不到这一点。

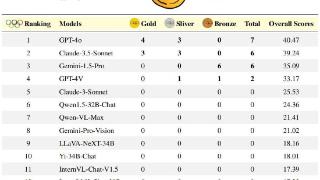

和人类一样,参加测试的模型也不尽相同。总的来说,GPT-4虽然并非无懈可击,但参加测试的表现比其他模型好。

麦克米伦-斯科特怀疑,这种所谓的“封闭”模型(即操作代码保密)“在后台编入了其他机制”来解答数学问题。

然而在现阶段,将决定权交给大语言模型是不可想象的。但为什么不利用它们奇怪的思维方式来帮助思考呢?

穆索莱西教授认为,另一种方法是训练它们在遇到相应情况时回答“我不太确定”。

以上内容为资讯信息快照,由td.fyun.cc爬虫进行采集并收录,本站未对信息做任何修改,信息内容不代表本站立场。

快照生成时间:2024-06-12 21:45:02

本站信息快照查询为非营利公共服务,如有侵权请联系我们进行删除。

信息原文地址: