- 我的订阅

- 科技

我们正处于一个信息大暴发的时代,每天都能产生数以百万计的新闻资讯!

虽然有大数据推荐,但面对海量数据,通过我们的调研发现,在一个小时的时间里,您通常无法真正有效地获取您感兴趣的资讯!

头条新闻资讯订阅,旨在帮助您收集感兴趣的资讯内容,并且在第一时间通知到您。可以有效节约您获取资讯的时间,避免错过一些关键信息。

微软研究院推出orca2llm

类别:科技 发布时间:2023-11-22 11:08:00 来源:浅语科技

11月22日消息,微软研究院(MicrosoftResearch)近日发布新闻稿,推出了相比较主流语言模型更小的Orca2LLM,不过依然可以回答一些复杂问题。

微软Orca2共有70亿和130亿两种尺寸,部分融合了Llama2LLM参数,通过融合定制的高质量合成数据,提供更准确、更优秀的合成数据。

微软表示Orca2使用扩展的、高度定制的合成数据集进行训练。Orca2支持分步处理、回忆然后生成、回忆-原因-生成、提取-生成和直接回答等各种推理技术,同时还能为不同的任务选择不同的解决方案策略。

Orca2模型相比较Llama2和WizardLM等大型语言模型,在痛苦理解、常识推理、多步推理、数学问题解决、阅读理解等方面更为优秀。

微软表示:“我们的初步结果表明,Orca2的性能明显优于类似尺寸的模型。它还达到了与至少大10倍的模型相似或更好的性能水平,展示了为较小模型配备更好推理能力的潜力。”

以上内容为资讯信息快照,由td.fyun.cc爬虫进行采集并收录,本站未对信息做任何修改,信息内容不代表本站立场。

快照生成时间:2023-11-22 15:45:25

本站信息快照查询为非营利公共服务,如有侵权请联系我们进行删除。

信息原文地址:

更多关于微软,研究院,研究,微软,模型,推理的资讯:

...者简介本文第一作者陈三元是哈尔滨工业大学和微软亚洲研究院的联合培养博士,他从2020年开始担任MSRA自然语言计算组的实习研究员,研究兴趣主要是用于语音和音频处理的预训练语言

2024-07-25 09:34:00

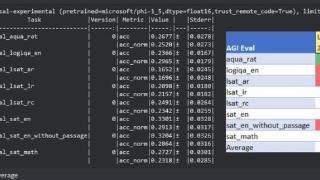

9月12日消息,微软研究院昨日发布了名为phi-1.5的全新预训练语言模型,共有13亿个参数,适用于QA问答、聊天格式和代码等等场景

2023-09-13 04:52:00

...放创新生态。

值得一提的是,会上,北京通用人工智能研究院、中国信通院、北京大学、清华大学、中国人民大学、中国科学院自动化研究所、智源研究院、海天瑞声、智谱AI、腾讯、中国中

2024-04-28 11:00:00

...这些模型,并将其部署到本地进行离线推理。此外,微软研究院还开发了Florence模型,允许用户分析和理解图像、视频和语言

2023-11-21 10:45:00

...至超过NPU/GPU!没错,为了优化模型端侧部署,微软亚洲研究院提出了一种新技术——T-MAC。这项技术主打性价比,不仅能让端侧模型跑得更快,而且资源消耗量更少。咋做到的??

2024-08-10 09:52:00

...再比如,零一万物预训练负责人黄文灏来自智源人工智能研究院,曾担任健康计算研究中心技术负责人。加入智源前,他曾任微软亚洲研究院研究员,负责自然语言理解、实体抽取、对话理解以及人

2023-11-06 12:13:00

...了香港中文大学多媒体实验室;2005年至2007年在微软亚洲研究院工作,担任视觉计算组主任;2008年在深圳先进技术研究院多媒体集成技术研究室工作,担任主任和研究员。汤晓鸥主

2023-12-18 22:02:00

...产业和生态发展的重要途径。国内也已是一大趋势,智源研究院的悟道3.0、百川智能的 Baichuan-7B和 Baichuan-13B

2023-07-20 01:00:00

...」目标控制方法Moxin-7B:一个完全开源的大语言模型微软研究院:创建多用途、高质量 3D 资产智源推出视觉条件多视角扩散模型Turbo3D

2024-12-13 09:19:00

更多关于科技的资讯:

《2026胡润全球富豪榜》昨发布厦门上榜企业家人数大幅增加字节跳动创始人张一鸣蝉联中国首富,安踏丁世忠仍是厦门首富厦门网讯(厦门日报记者 李晓平)昨日

2026-03-06 08:33:00

各大商场景区纷纷推出优惠活动,鲜花依旧是热卖品项。图为市民在天虹超市选购鲜花。厦门网讯(文/图 厦门日报记者 沈彦彦)“三八”妇女节临近

2026-03-06 08:33:00

全国政协委员张云泉。中国网3月6日讯(记者 谢露莹)今年是“十五五”规划开局之年,如何在新一轮科技革命和产业革命加速演进中占先机

2026-03-06 08:48:00

全国第一河北算力指数折射发展新动能整理/河北日报记者 米彦泽 制图/喻萍算力是数字经济时代的新型生产力,是人工智能的基石之一

2026-03-06 09:18:00

覆盖率100%共享智造赋能107个重点产业集群■阅读提示2024年以来,河北省委、省政府审时度势,以“共享智造”为钥,开启县域特色产业跃升之门

2026-03-06 09:18:00

【宅男财经|财眼观两会】全国政协委员、新希望集团董事长刘永好接受中新经纬采访时称,作为民营企业家,最关注的是民营企业的健康

2026-03-06 10:08:00

借力资本市场,聚力燕赵智造。3月7日,河北资本市场大讲堂系列活动第五期将在沧州举办。活动聚焦股权投资关键领域,特邀国内创投领军机构深创投集团核心专家团队

2026-03-06 09:14:00

王冠一摘要:在信息化深入发展的背景下,企业会计工作正面临数据规模扩大、业务流程加速以及管理需求升级等多重变化。以数字技术为核心的会计创新成为推动企业财务治理能力提升的关键途径

2026-03-06 06:44:00

今年2月13日,一家名叫“月境未来”的科技公司在上城区正式成立。你可能没听过这个名字。但两个月前,那款刷爆朋友圈的App——“死了么”

2026-03-06 07:45:00

胶东在线3月5日讯(通讯员于永真徐冰鑫)“以前查退休档案得跑两三趟,现在手机上点点,半小时就收到电子证明,太方便了!” 家住山东莱阳市的张阿姨

2026-03-05 23:14:00

3月5日,针对近日网络流传阿里巴巴“千问模型核心团队集体离职”“开源策略调整”等不实信息,阿里集团向媒体辟谣表示:1、目前千问模型团队稳定

2026-03-05 22:29:00

中新经纬3月5日电 《政府工作报告》起草组成员、国务院研究室副主任陈昌盛表示,要降低中小企业应用大模型的成本,鼓励地方搞一些算力

2026-03-05 22:19:00

近日,上海华瑞银行研究课题《信用风险评估建模中目标表现期选择的实证研究》,获评上海市银行同业公会2025年度“上海银行业发展研究优秀成果”

2026-03-05 17:15:00