- 我的订阅

- 科技

我们正处于一个信息大暴发的时代,每天都能产生数以百万计的新闻资讯!

虽然有大数据推荐,但面对海量数据,通过我们的调研发现,在一个小时的时间里,您通常无法真正有效地获取您感兴趣的资讯!

头条新闻资讯订阅,旨在帮助您收集感兴趣的资讯内容,并且在第一时间通知到您。可以有效节约您获取资讯的时间,避免错过一些关键信息。

清华教授唐杰:Scaling Laws虽被质疑,但至今仍是提高大模型性能的重要方法

清华大学计算机系讲席教授、人工智能研究院基础模型研究中心主任唐杰

出品|搜狐科技

作者|郑松毅

2024年已过半,大模型之争热度不减,通往AGI的路究竟该怎么走?

近日,清华大学计算机系讲席教授、人工智能研究院基础模型研究中心主任唐杰分享了对大模型发展历程的看法,并对AGI未来发展提出了一些思考。

他强调,人工智能大模型已成为国际科技“必争之地”,实现国产全自研、自主可控的人工智能基础模型迫在眉睫。

“除了超大算力、数据、算法创新需求,大模型创新发展面临的挑战还包括:打造安全可信的软硬件系统,同时大模型的应用需求也更加动态多样,要求对大模型的不同层次进行深入研究。”

回顾大模型发展历程,唐杰认为可分为四个阶段:算法之战(2018-2020),模型之战(2020-2022),产业落地之战(2023),及AGI元年(2024)。

自2017年谷歌提出Transformer机器学习模型架构后,该架构迅速席卷了整个人工智能领域,成为自然语言处理等相关研究的主要方法。

2018至2020年是算法创新年,先后出现了基于Transformer的BERT、GPT/GPT-2/GPT-3、T5等基于大规模无标注数据自监督学习的大规模预训练算法。这些算法模型均在大数据支持下拥有较大规模模型参数,具备较强的通用能力,可完成多场景任务,显著降低学习成本、提高学习效率。

2020至2022年,迎来了模型之战。GPT-3(拥有1750亿参数)是这一战的起点,随后全球范围内掀起了一股大模型研究的热潮,谷歌、Meta等公司开始不断发布百亿到千亿的大型语言模型,开源大语言模型也开始受到关注。

唐杰指出,“国内一直缺少原创的开源千亿基座模型,更重要的是产学研各界对大模型的发展和产业化还没有形成共识,对于应该发展大模型还是转而发展小模型,大家还没有达成统一认识。”

2022年11月30日,ChatGPT正式发布,唤醒了所有人对大模型的认知。大模型的发展不再仅限于模型技术的发展和模型训练本身,更重要的是如何实现模型的产业化应用。大模型开始在各个领域开花结果,在金融、互联网和教育等众多行业落地。

随后,全国多个产业纷纷投身大模型:短期的做AI升级,原来用分类算法、小模型实现的开始用大模型替代;中期的开始研究自己的定制化大模型。于是各种大模型纷纷推出,一时间形成了“百模大战”的情形。仅此一年,据不完全统计,全国实现大模型初步应用的企业和部门有数千个。2023年也被称为大模型产业落地元年。

时至今日,OpenAI在2024年初推出了文本到视频生成模型Sora,被认为是目前最好的视频生成模型,让大家看到了构建物理世界通用模型的可能路径。

唐杰分析,“OpenAI极有可能在2024年推出下一代模型GPT-5,也许会有全新的代号,无论如何比较肯定的是其认知能力将带来通用人工智能的再一次变革。其下一代模型在技术上可能解决目前ChatGPT中存在的事实性以及推理能力的缺陷,实现更精细的语义理解、多模态(文本、图像、语音、视频等)输入和输出,具备更强的个性化能力。”

“人工智能的发展会更多瞄向通用人工智能,实现AI的自我解释、自我评测和自我监督,构建超过人类水平的超级认知智能(super intelligence),并且确保模型的表现符合人类的价值观和安全标准。”

谈及AGI研究面临的挑战,唐杰认为还有很多基础理论问题尚未得到根本解决。

很多人疑惑,未来AGI之路在哪里?

在他看来,这可能是所有做大模型研究的学者不断思考的事情。国内外前沿科技公司和科研机构基本上都形成了顶尖的大模型团队,这源于对创新型顶尖人才的汇聚,以及对基于大模型的AGI之路的执着和技术积累。

OpenAI曾经在看不到前景和没有明显效果的阶段(2018~2021年),仍然坚定地投入大量人力和算力,这种长期的坚持和纯粹的创新精神是成功的必要条件。

AGI是否能够通过大模型的缩放定律(Scaling Laws)来实现?一直以来也是备受关注的问题。

唐杰认为,缩放定律描述了大模型性能与其参数量、数据规模、计算量之间的关系。虽然备受质疑,但直到今天,可能高质量的缩放仍然是提高大模型性能的重要方法。

“一方面,这几个因素相互关联,参数量更大的语言模型需要更多的高质量数据和训练量,以兼顾文本理解和生成任务上的规模扩展效果。另一方面,多模态超大规模预训练模型的兴起,要求模型算法具备在多模态数据(如图片、视频)输入输出条件下的规模扩展。这就要求在模型架构、训练算法、人类意图对齐等方法上不断创新。”

在人工智能的发展历程中,类脑研究一直在为其带来启发。

唐杰表示,“从理论的角度,AGI也需要参考人脑智能的实现机理。基于大模型的AGI或者说机器智能不一定要和人脑认知的机理一样,但剖析人脑的工作机理也许可以更好地启发AGI的实现。”

在大模型基座方面,目前的大模型主要基于Transformer架构,有三种主流架构:编码器(encoder-only,例如BERT)、编码器-解码器(encoder-decoder,例如T5),以及解码器(decoder-only,例如GPT)。这几个架构都是国外设计并流行起来的。

“国内在原始创新和自主研发方面严重欠缺。清华大学和智谱AI结合了BERT和GPT的优势,设计了GLM架构。但如何从本质上改进预训练模型的基座能力,实现Transformer架构上的颠覆式创新还存在巨大挑战。”

他指出,“以GPT-4为代表的一系列语言模型基于互联网上海量的文本语料进行预训练,在语义理解、指令遵循等方面展现出了惊人的能力。然而,这些语言模型只能以文本形式处理内容,并无法处理图片等其他模态的信息。”

他补充解释道,形如GPT-4V等视觉文本多模态模型通过一个视觉编码器(Vision Encoder)和语言模型建立连接,使得模型初步具备一定的图片理解能力,但这种文本视觉的交互仍然处于浅层。如何利用好互联网上海量的多模态语料(图片、音频、视频)进行大规模训练仍然具有挑战。

2023年7月,OpenAI公布了由其首席科学家伊利亚·苏茨克维(Ilya Sutskever)和首席强化学习专家詹·雷克(Jan Leike)发起的超级对齐计划(Superalignment),目标就是实现机器自动对齐人类智能和人类价值观,实现模型的自我反思和自我监控。

唐杰认为,真正做到管理AI风险还有很长的路要走,目前还是依赖于人类监管AI的能力。一个可能的方法是建立一个与人类水平相当的自动对齐系统,让AI能够自己判断自己的行为和输出。这不仅需要设计全新的算法实现可扩展训练、自动模型结果验证、自动对超级对齐结果进行评估,同时还需要超大规模的算力迭代实现超级智能对齐。

在很多人看来,芯片短缺扼住了人工智能发展的喉咙。

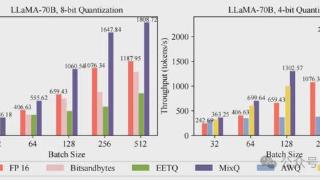

他表示,传统的大模型研究思维一直是围绕芯片进行算法设计,导致当前所有大模型的基础算法都只能在H100/A100类似体系架构上进行设计与实现。当前国产芯片被“卡脖子”的最关键技术是单GPU芯片的计算能力和芯片间的高速通信,尤其是后者。

“因此,有必要从底层开始,围绕大模型/AGI算法设计研发新型芯算一体大模型机。核心思想是首先设计全新的大模型算法,然后针对新算法优化内存使用,提升芯片计算效率和芯片间的通信效率。”

他指出,“通过设计全新的大模型算法和整合专用硬件构建全新大模型训练体系结构,实现全新的软硬体系架构也许是一条解决芯片被“卡脖子”的方法,实现我们自己的大模型之路。”返回搜狐,查看更多

责任编辑:

以上内容为资讯信息快照,由td.fyun.cc爬虫进行采集并收录,本站未对信息做任何修改,信息内容不代表本站立场。

快照生成时间:2024-06-05 21:45:02

本站信息快照查询为非营利公共服务,如有侵权请联系我们进行删除。

信息原文地址: