- 我的订阅

- 科技

我们正处于一个信息大暴发的时代,每天都能产生数以百万计的新闻资讯!

虽然有大数据推荐,但面对海量数据,通过我们的调研发现,在一个小时的时间里,您通常无法真正有效地获取您感兴趣的资讯!

头条新闻资讯订阅,旨在帮助您收集感兴趣的资讯内容,并且在第一时间通知到您。可以有效节约您获取资讯的时间,避免错过一些关键信息。

美媒:GPT-4通过图灵测试

本文转自:参考消息

参考消息网5月21日报道 据美国未来主义网站5月17日报道,美国开放人工智能研究中心(OpenAI)的GPT-4是如此逼真,它可以欺骗超过50%的人类测试对象,让他们认为自己在和人类对话。

在一篇新论文中,来自加利福尼亚大学圣迭戈分校的认知科学研究人员发现,在超过一半的时间里,人们会把GPT-4写的文本误认为是有血有肉的人写的。换句话说,大语言模型毫不费力地通过了图灵测试。

研究人员进行了一项简单的测试:他们要求大约500人与一名真人或一个基于GPT-4的聊天机器人进行5分钟的基于文本的对话。然后这些研究人员会问受试者,他们认为自己刚才在和真人还是人工智能交谈。

正如这些科学家在尚未经过同行评议的论文中所报告的那样,结果显而易见:54%的受试者以为自己之前在和人类对话,但其实他们在与OpenAI的产品聊天。

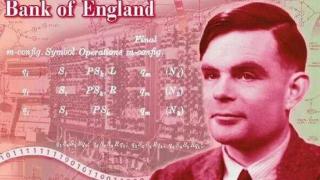

图灵测试最早是由计算机科学先驱阿兰·图灵在1950年提出的,它更像是一个思想实验,而不是一系列实际测试。在最初的测试中,图灵安排了三名“参与者”——一名人类考官,一名不确定是人类还是机器的见证人,还有一名人类观察者。

加州大学圣迭戈分校的研究人员在研究中调整了图灵最初的三人配置,通过消除人类观察者来简化设置。然后,他们让500名参与者与四类见证者中的其中一类进行交流。这四类见证者分别是:另一个人、GPT-3.5、GPT-4或来自20世纪60年代的原始的“伊丽莎”聊天机器人。

卡梅伦·琼斯和本杰明·伯根假设,研究对象多数时候大体上能够分辨他们是在与人类还是“伊丽莎”交流,但当与OpenAI的大语言模型交流时,他们的正确率基本在50%。

事实证明,他们的预判相当准确。除了54%的人把GPT-4误认为人之外,刚好有50%的人把GPT-3.5(也就是最新大语言模型的直接前身)误认为人。与22%的人把“伊丽莎”误认为人相比,这个比例相当惊人。

尽管仍在评议中,但这篇论文已经在科技界掀起波澜,以太坊联合创始人维塔利克·布捷林在社交网络上宣称,在他看来,加州大学圣迭戈分校的研究“算是说明GPT-4通过图灵测试了”。

虽然其他人也声称观察到OpenAI的GPT模型通过了图灵测试,但布捷林的认可使这项研究脱颖而出——不过我们可能必须等待论文经过同行评议,才能发表任何更重大的声明。

以上内容为资讯信息快照,由td.fyun.cc爬虫进行采集并收录,本站未对信息做任何修改,信息内容不代表本站立场。

快照生成时间:2024-05-21 17:45:07

本站信息快照查询为非营利公共服务,如有侵权请联系我们进行删除。

信息原文地址: