- 我的订阅

- 科技

我们正处于一个信息大暴发的时代,每天都能产生数以百万计的新闻资讯!

虽然有大数据推荐,但面对海量数据,通过我们的调研发现,在一个小时的时间里,您通常无法真正有效地获取您感兴趣的资讯!

头条新闻资讯订阅,旨在帮助您收集感兴趣的资讯内容,并且在第一时间通知到您。可以有效节约您获取资讯的时间,避免错过一些关键信息。

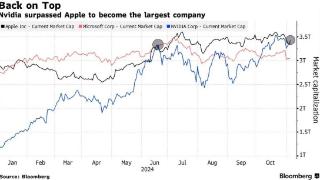

英伟达展示blackwell平台,否认推迟上市

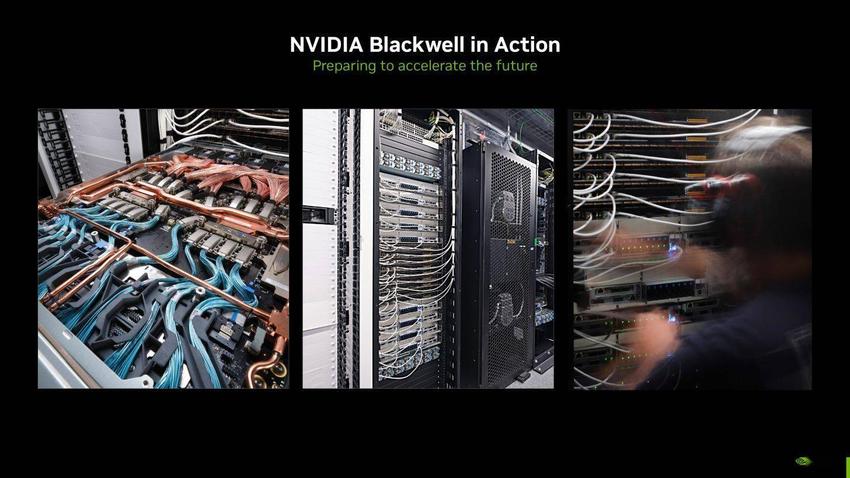

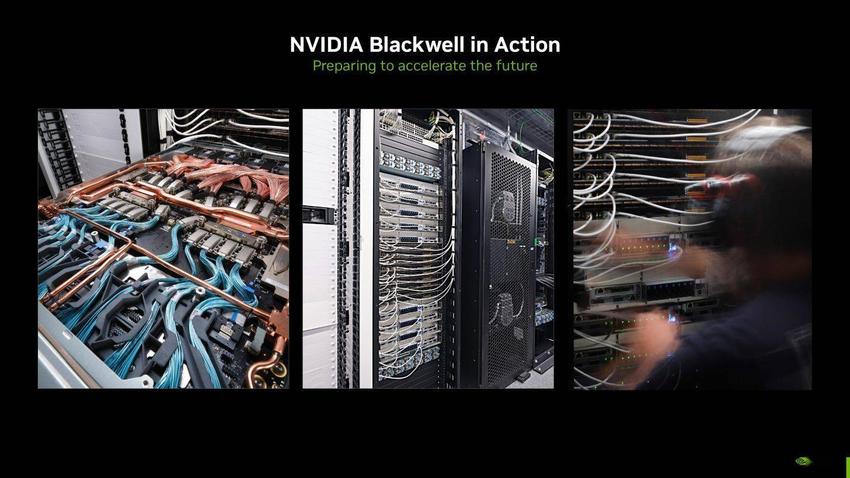

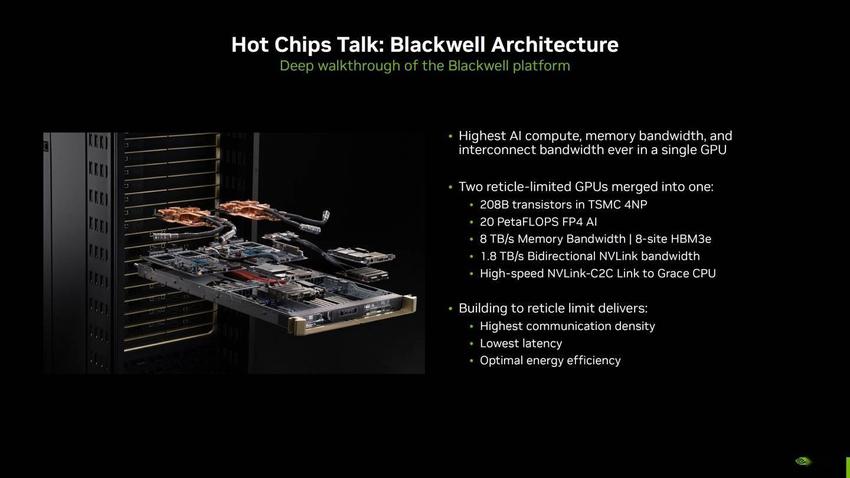

8月24日消息,英伟达邀请部分媒体举办吹风会,向科技记者首次展示了Blackwell平台。英伟达将出席8月25-27日举办的HotChips2024活动,展示Blackwell平台在数据中心投入使用的相关情况。

否认Blackwell推迟上市消息

英伟达在本次吹风会上,驳斥了Blackwell推迟上市的消息,并分享了更多数据中心Goliath的相关信息。

英伟达在吹风会上演示了Blackwell在其一个数据中心的运行情况,并强调Blackwell正在按计划推进,并将于今年晚些时候向客户发货。

有消息称Blackwell存在某种缺陷或问题,今年无法投放市场,这种说法是站不住脚的。

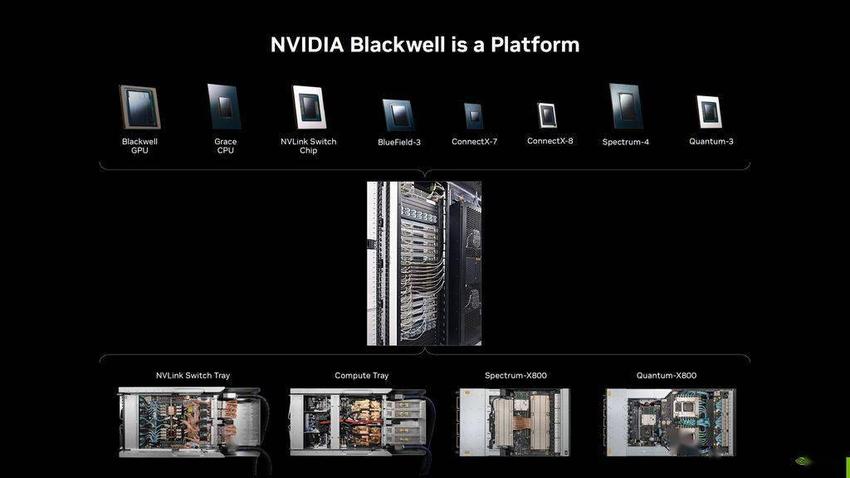

Blackwell简介

英伟达表示Blackwell不仅仅是一款芯片,它还是一个平台。就像Hopper一样,Blackwell包含面向数据中心、云计算和人工智能客户的大量设计,每个Blackwell产品都由不同的芯片组成。

IT之家附上包括的芯片如下:

BlackwellGPU

GraceCPU

NVLINKSwitchChip

Bluefield-3

ConnectX-7

ConnectX-8

Spectrum-4

Quantum-3

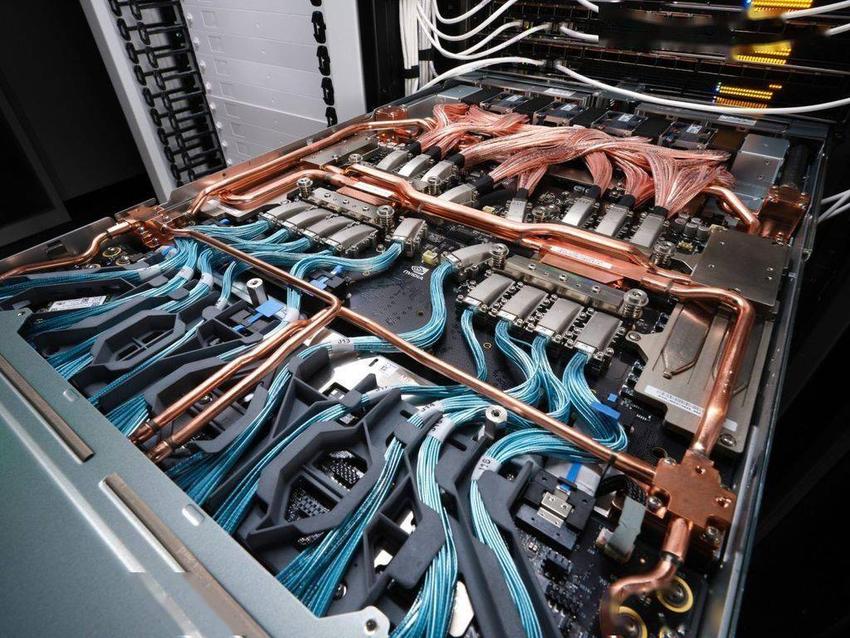

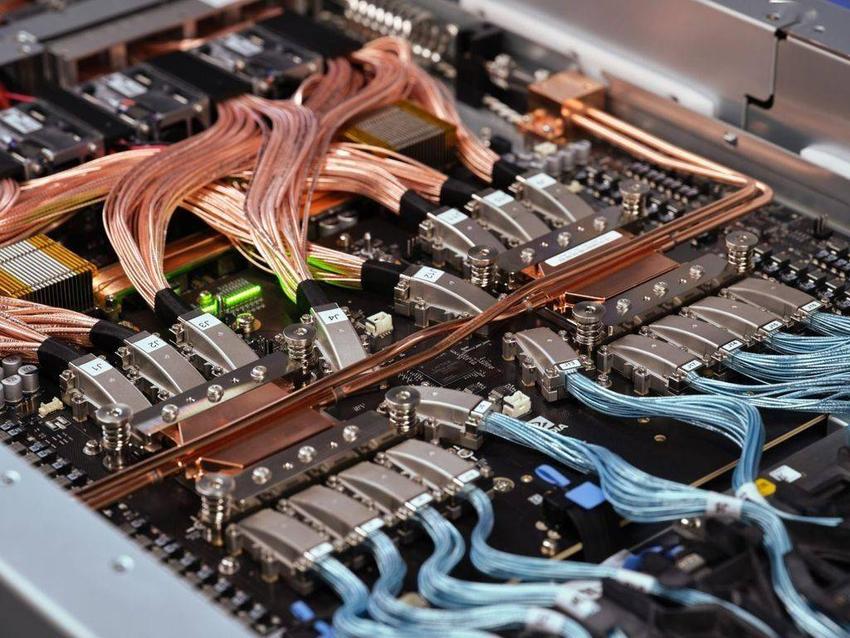

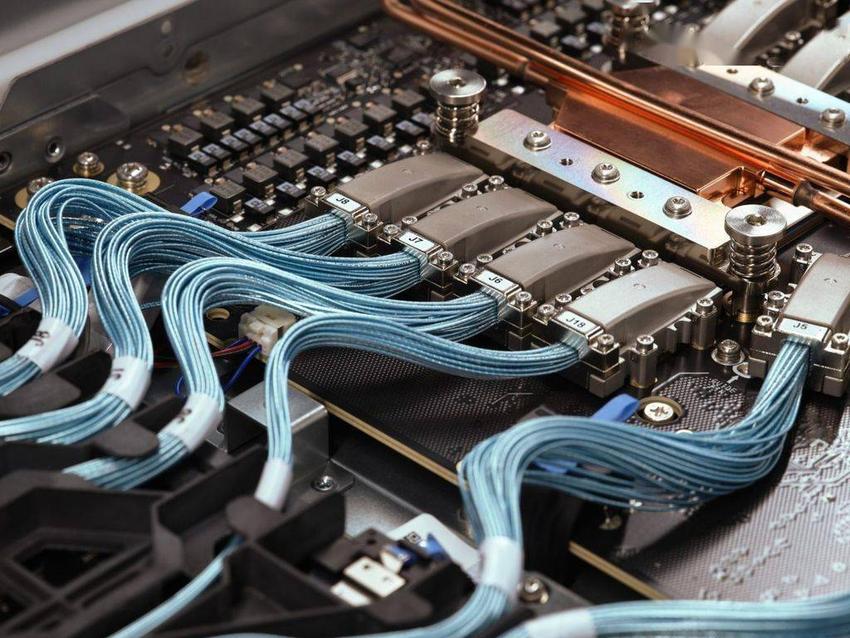

Blackwell桥架

英伟达还分享了Blackwell系列产品中各种桥架的全新图片。这些是首次分享的Blackwell桥架图片,展示了设计下一代数据中心平台所需的大量专业工程技术。

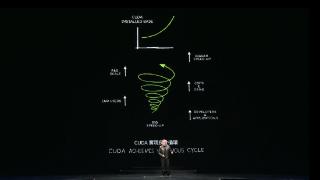

目标万亿参数AI模型

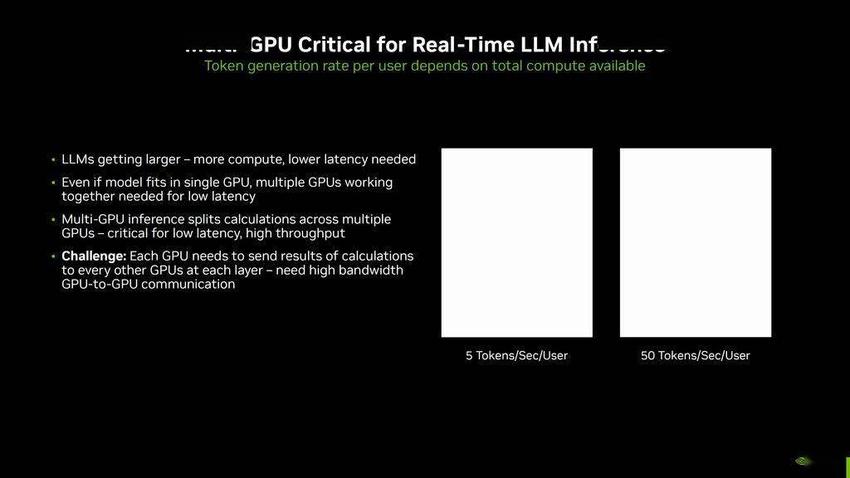

Blackwell旨在满足现代人工智能的需求,并为大型语言模型(如Meta的405BLlama-3.1)提供出色的性能。随着LLMs的规模越来越大,参数也越来越多,数据中心将需要更多的计算和更低的延迟。

多GPU推理方法

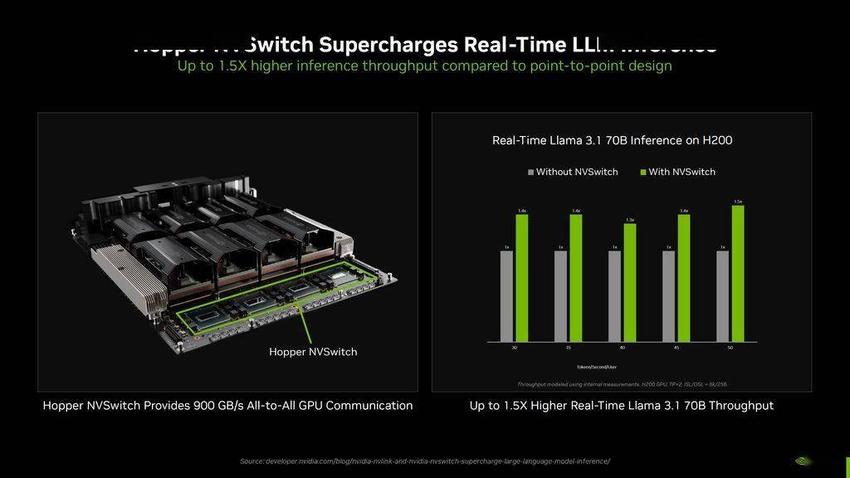

多GPU推理方法是在多个GPU上进行计算,以获得低延迟和高吞吐量,但采用多GPU路线也有其复杂性。多GPU环境中的每个GPU都必须将计算结果发送给每一层的其他GPU,这就需要高带宽的GPU对GPU通信。

多GPU推理方法是在多个GPU上进行计算,以获得低延迟和高吞吐量,但采用多GPU路线也有其复杂性。多GPU环境中的每个GPU都必须将计算结果发送给每一层的其他GPU,这就需要高带宽的GPU对GPU通信。

更快的NVLINK交换机

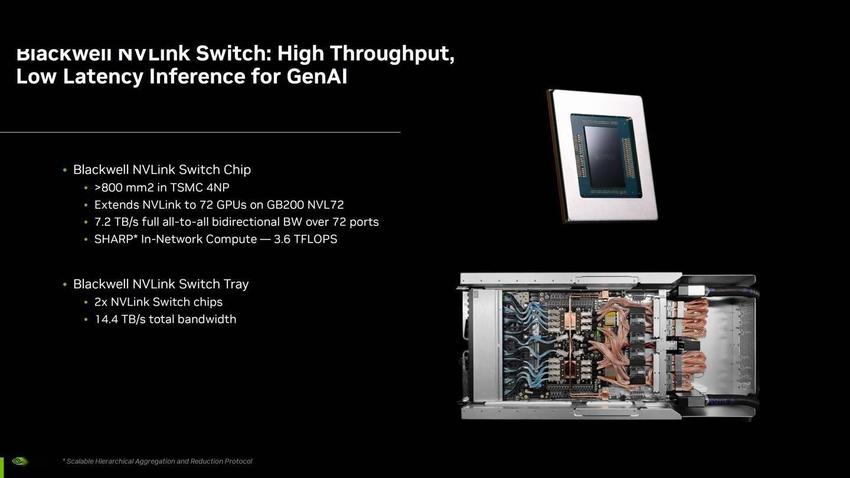

通过Blackwell,NVIDIA推出了速度更快的NVLINK交换机,将结构带宽提高了一倍,达到1.8TB/s。NVLINK交换机本身是基于台积电4NP节点的800mm2芯片,可将NVLINK扩展到GB200NVL72机架中的72个GPU。

该芯片通过72个端口提供7.2TB/s的全对全双向带宽,网内计算能力为3.6TFLOPs。NVLINK交换机托盘配有两个这样的交换机,提供高达14.4TB/s的总带宽。

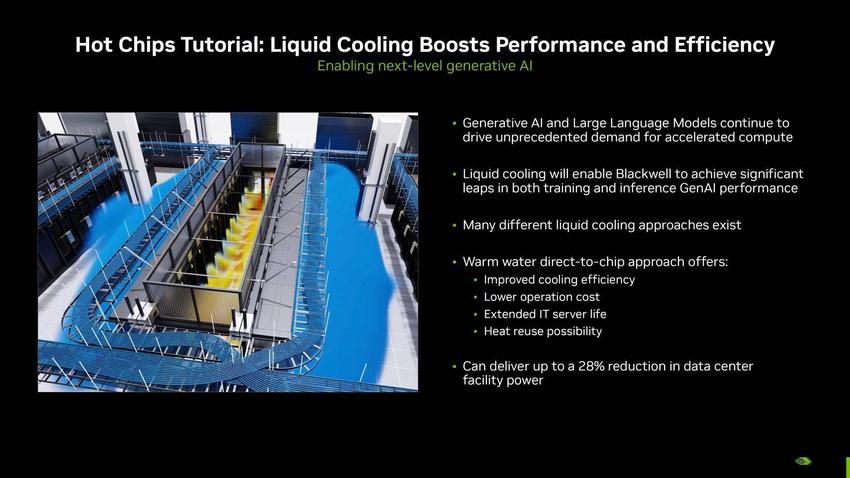

水冷散热

英伟达采用水冷散热,来提升性能和效率。GB200、GraceBlackwellGB200和B200系统将采用这些新的液冷解决方案,可将数据中心设施的电力成本最多降低28%。

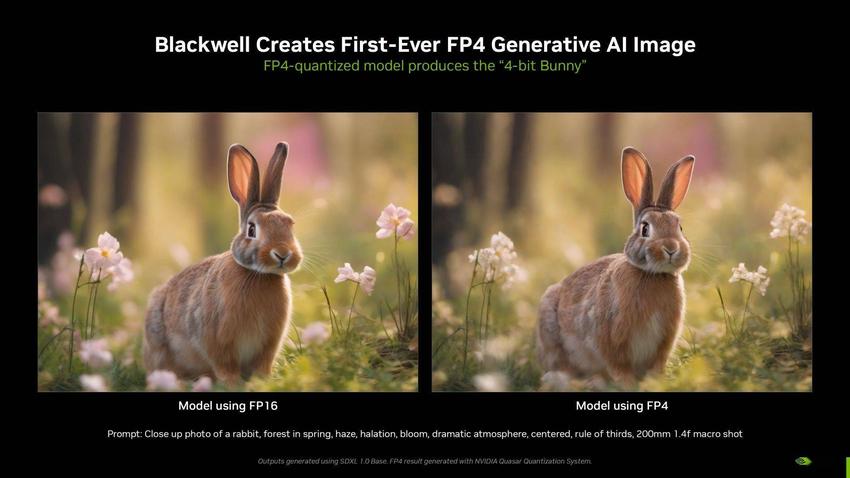

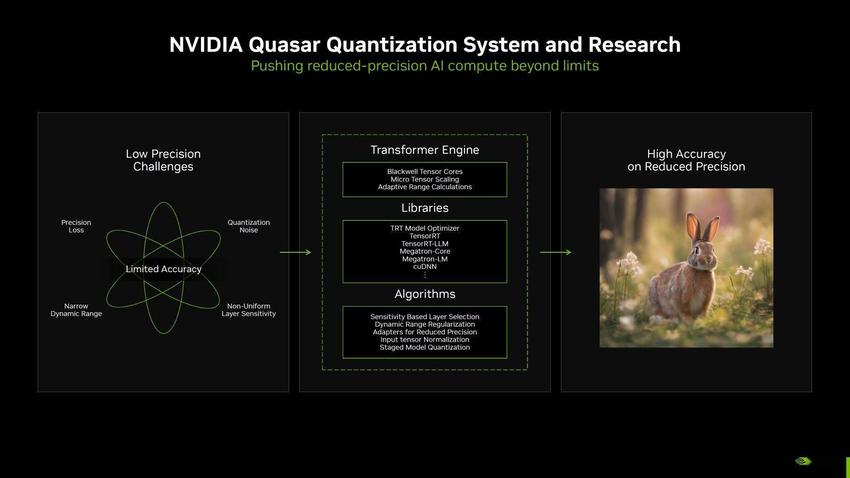

首张使用FP4计算生成的人工智能图像

英伟达™(NVIDIA®)还分享了全球首张使用FP4计算生成的人工智能图像。图中显示,FP4量化模型生成的4位兔子图像与FP16模型非常相似,但速度更快。

该图像由MLPerf在稳定扩散中使用Blackwell制作而成。现在,降低精度(从FP16到FP4)所面临的挑战是会损失一些精度。

以上内容为资讯信息快照,由td.fyun.cc爬虫进行采集并收录,本站未对信息做任何修改,信息内容不代表本站立场。

快照生成时间:2024-08-25 08:45:05

本站信息快照查询为非营利公共服务,如有侵权请联系我们进行删除。

信息原文地址: